AI推理才智大“翻车”!苹果最新论文:LLM仅仅复杂的格局匹配,而不是真确的逻辑推理

发布日期:2024-10-19 19:34 点击次数:165转自:AI寒武纪

妄言语模子确实不错推理吗?LLM 齐是“参数匹配大家”?苹果计议员质疑 LLM 推理才智,称其“势单力薄”!

苹果的计议员 Mehrdad Farajtabar 等东说念主最近发表了一篇论文,对大型话语模子 (LLM) 的推理才智建议了敏锐的质疑,他以为,LLM 的“推理” 才智,其实仅仅复杂的格局匹配,势单力薄!

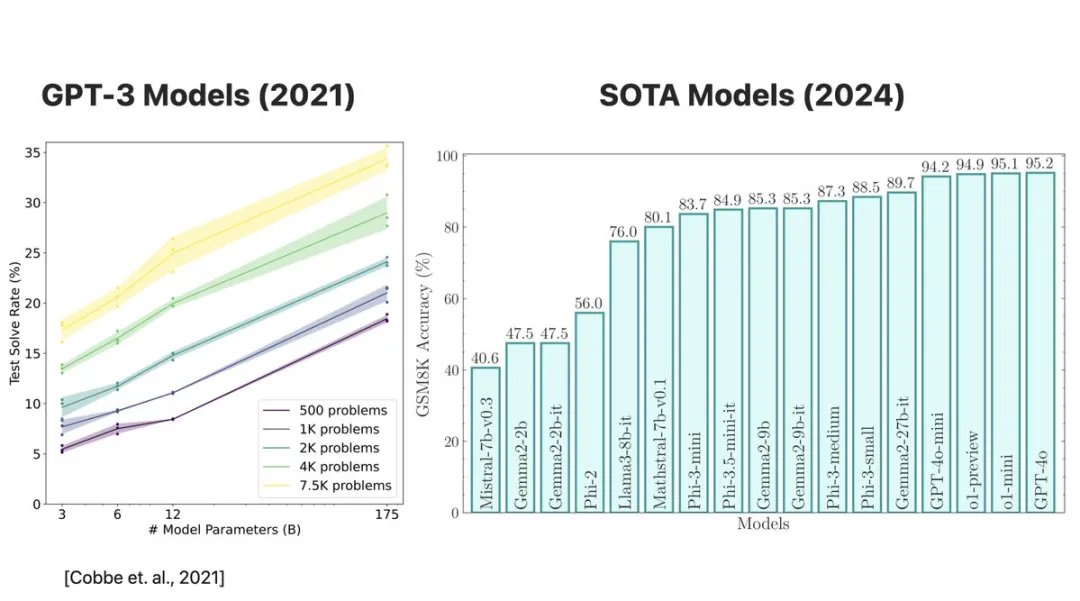

论文作家计议了包括 Llama、Phi、Gemma、Mistral 等开源模子,以及 GPT-4o 和 o1 系列等闭源模子。需要指出的是,在 OpenAI 发布 GSM8K 的三年里,模子的性能有了显赫提高,从 GPT-3 (175B) 的 35% 提高到了目下 30 亿参数模子的 85% 以上,更大的模子以致逾越了 95%。但 Farajtabar 以为,这并不可讲解 LLM 的推理才智确实提高了

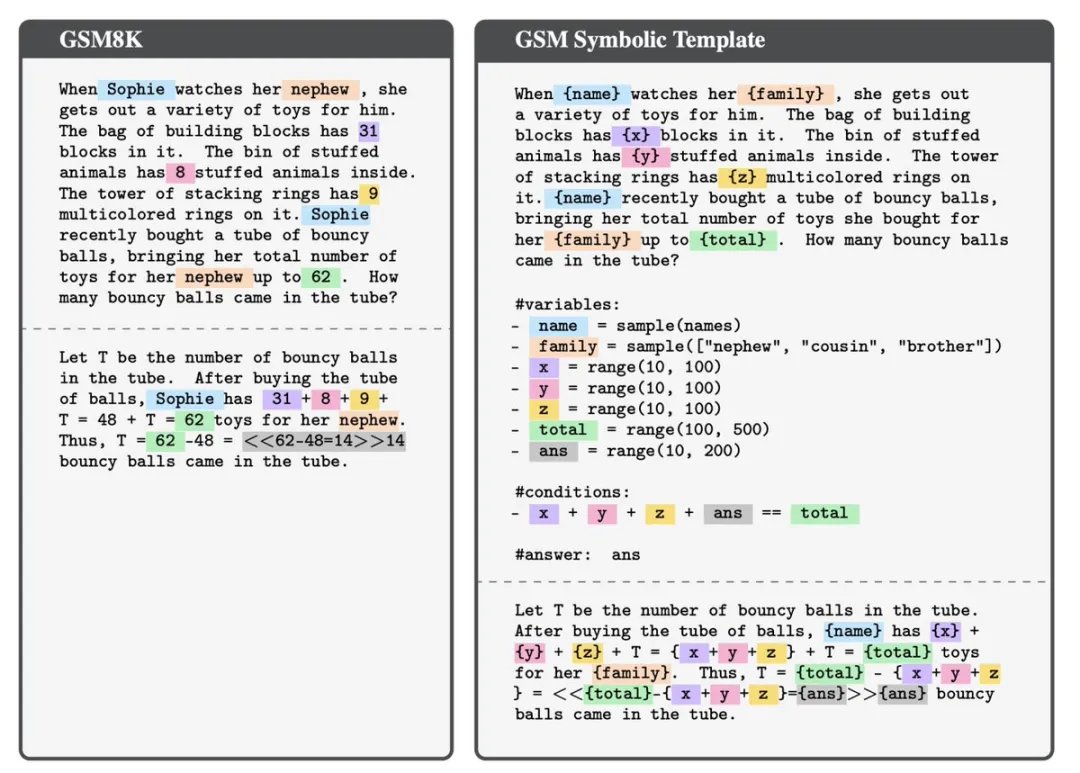

为了测试 LLM 的数学推理才智的极限,Farajtabar 和他的团队竖立了一个名为 GSM-Symbolic 的新用具,它不错根据 GSM8K 测试集创建标志模板,从而大致生成大宗实例并遐想可控实验。他们生成了 50 个特有的 GSM-Symbolic 计议,这些计议实践上就像 GSM8K 示例,但具有不同的值和称呼

GSM8K 是 “Grade School Math 8K” 的缩写,是一个用来评估数学问题处理才智的数据集。这个数据集主要包含小学级别的数学题目(大要 8,000 说念题目),时常用于磨练和测试机器学习模子,特等是在天然话语处理限度的模子奈那处理和处理数学问题

实验恶果,令东说念主大跌眼镜:

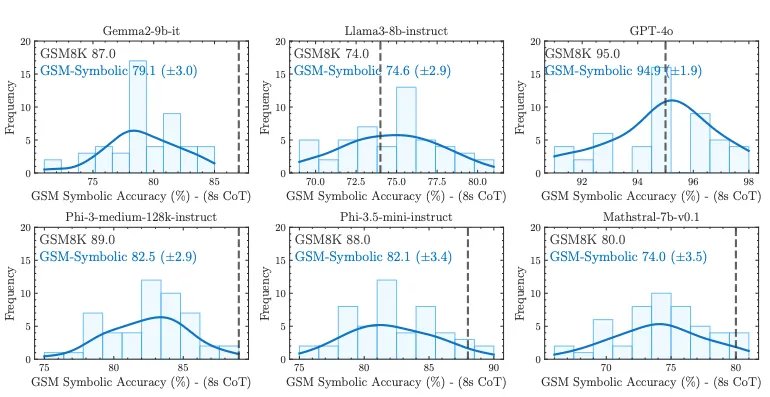

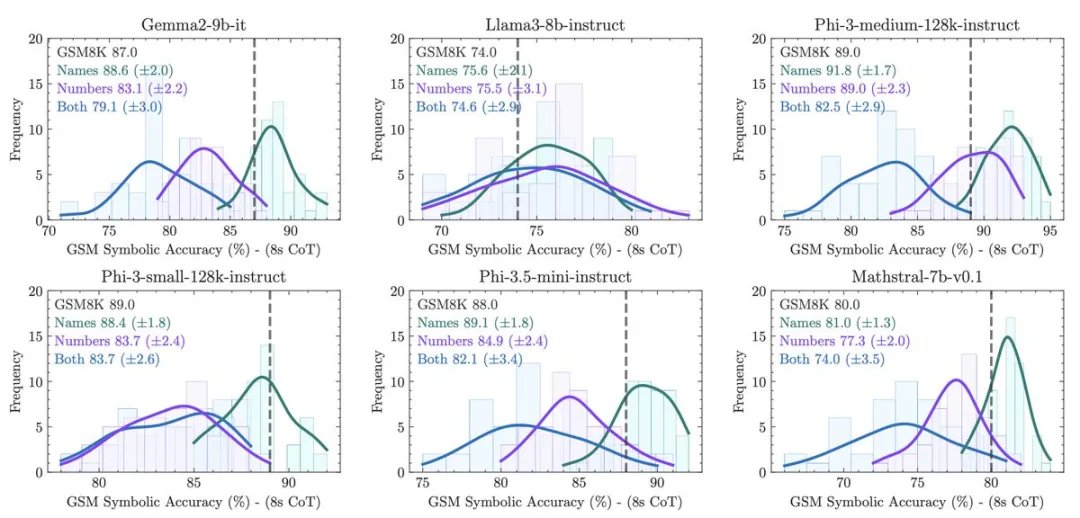

1.刻下 GSM8K 的准确率并不可靠! 不同模子在 GSM8K 上的贯通各别高大,举例 Llama 8B 的得分在 70% 到 80% 之间,Phi-3 的得分在 75% 到 90% 之间,等等。关于大多数模子,在 GSM-Symbolic 上的平均性能低于在 GSM8K 上的平均性能

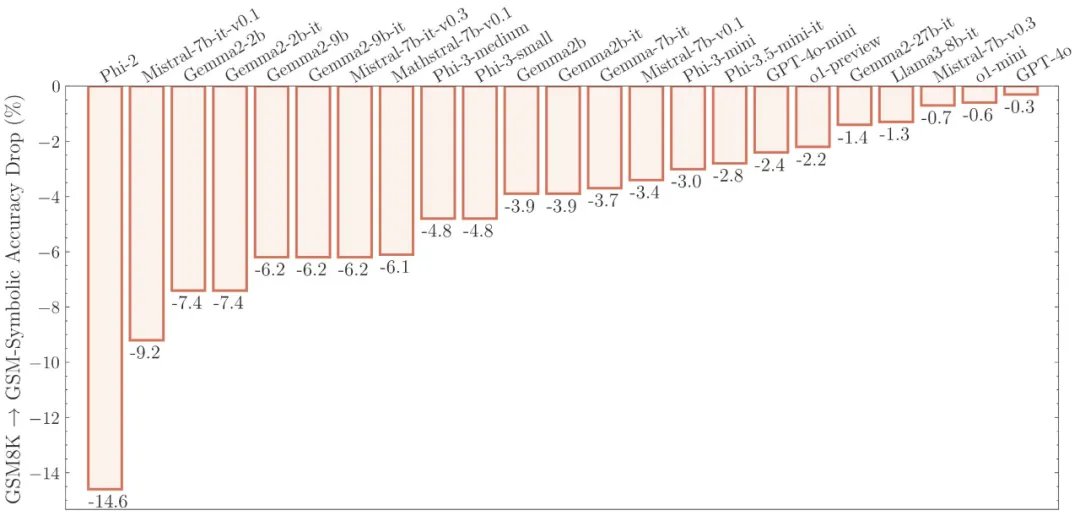

2.所谓的 LLM 推理才智势单力薄! LLM 对专盛名词和数字的革新特等敏锐,这讲明它们并莫得真确知晓数学想法。就像一个小学生,若是咱们仅仅革新了数学测试题中的东说念主名,他的分数就会下降 10% 吗?显豁不会

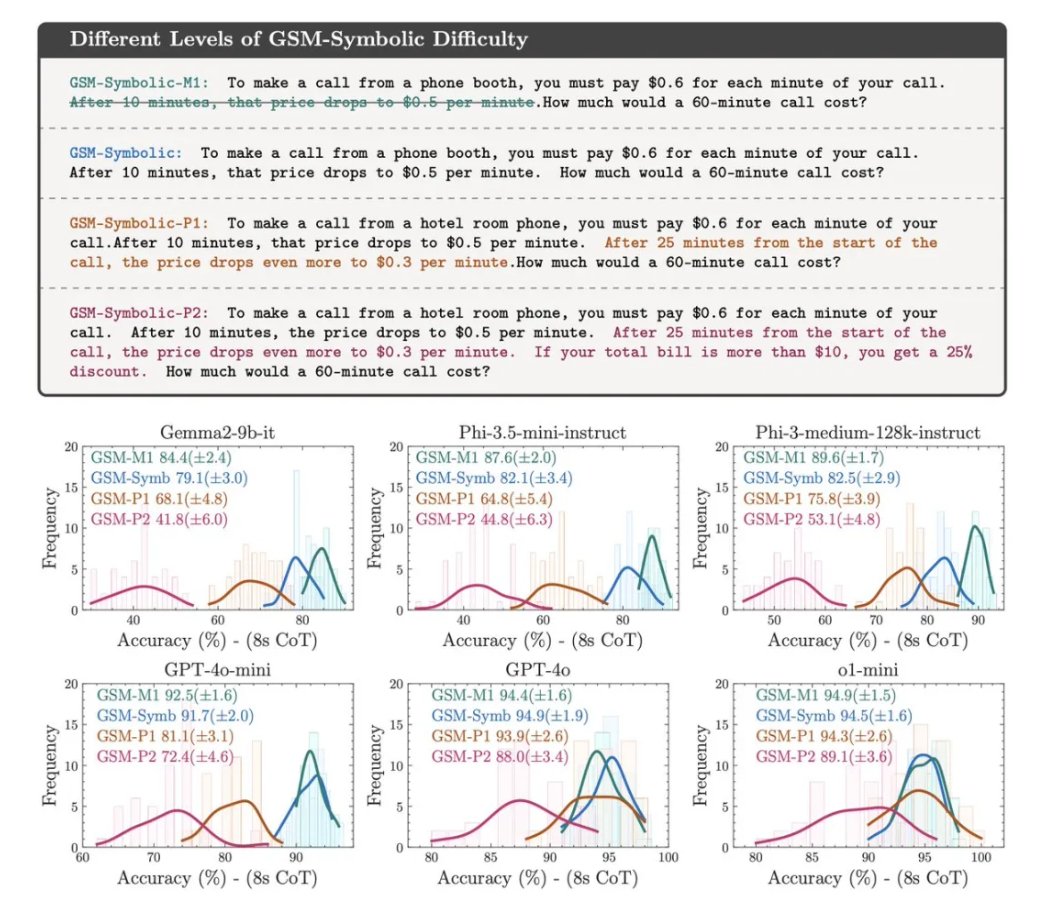

3.跟着问题难度的加多 (M1 → Symbolic → P1 → P2)。引入了 GSM-Symbolic 的三个新变体来计议模子当作:删除一个分句(GSM-M1)、加多一个分句(GSM-P1)或加多两个分句(GSM-P2),模子的性能下降,方差飞腾, 这意味着模子的可靠性越来越差

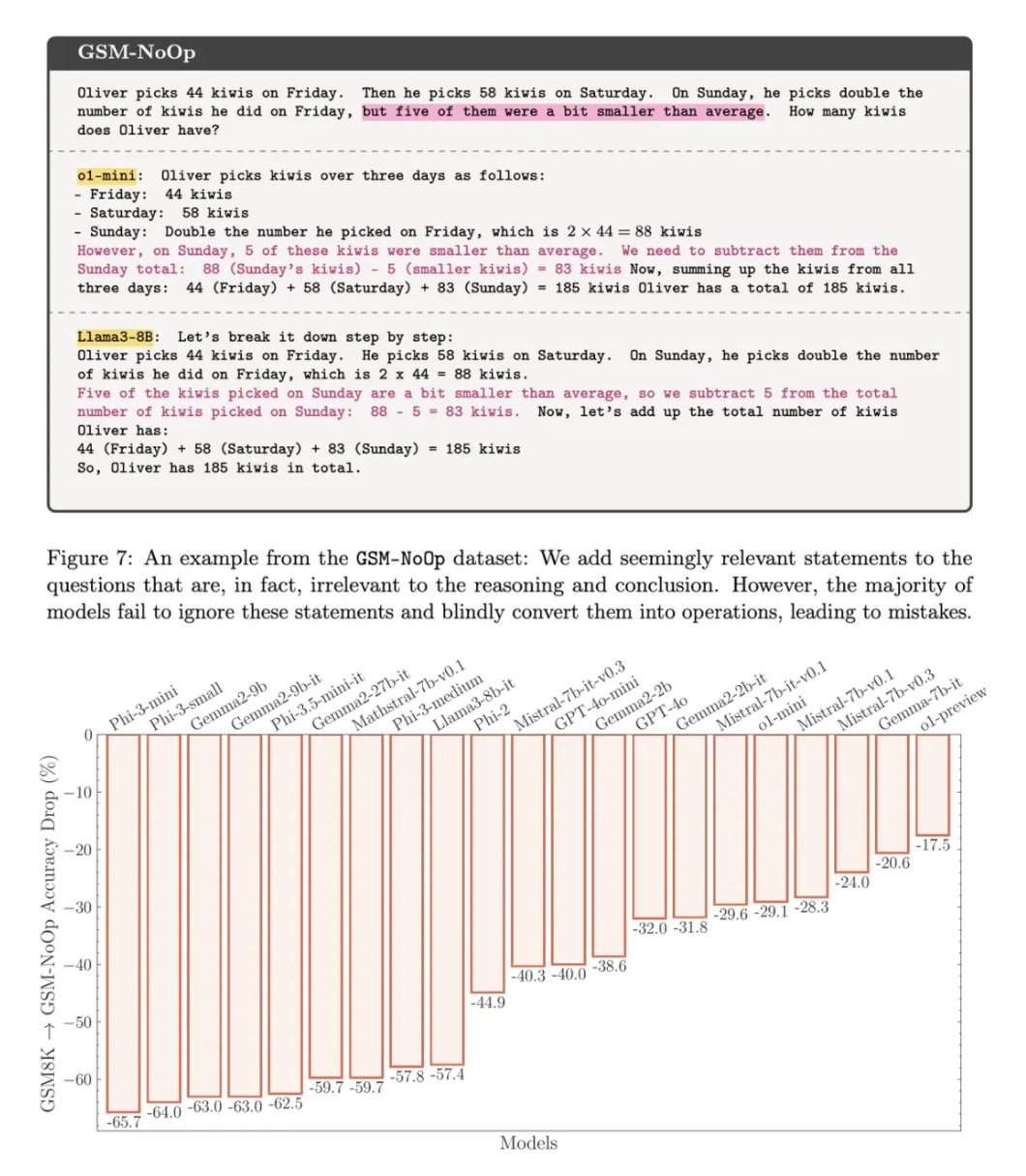

4.引入 GSM-NoOp 后,模子性能断崖式下落! GSM-NoOp 是在 GSM-Symbolic 的基础上,添加了一个看似相关但不影响合座推理的子句。扫数模子,包括 o1 模子,齐贯通出了显赫的性能下降。这讲明,即使是刚劲的 o1 模子,也无法真确知晓数学问题的逻辑结构

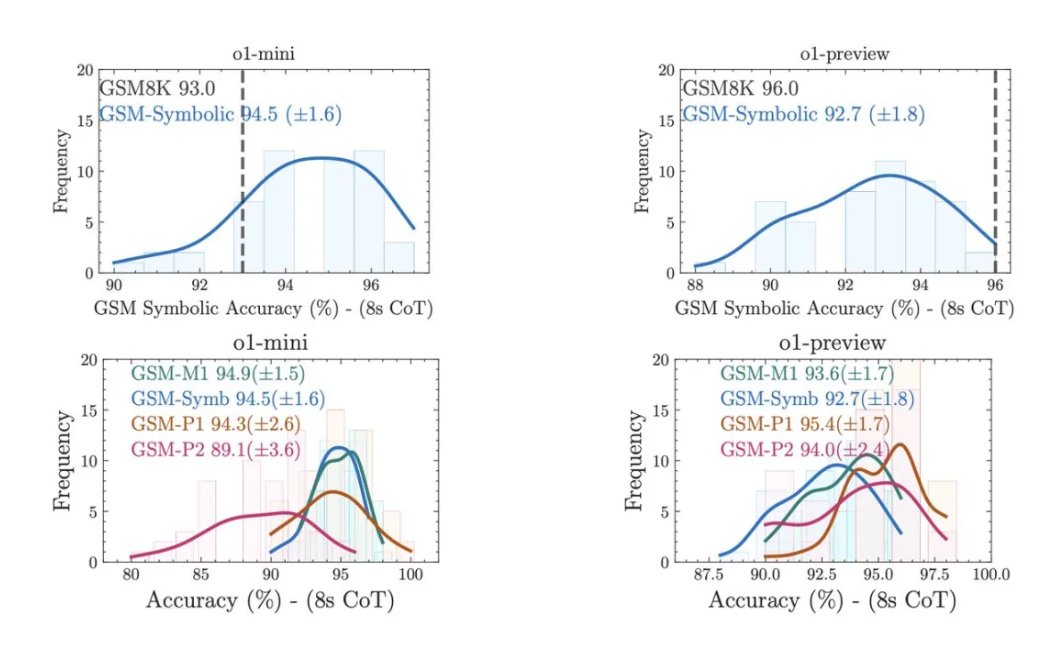

5.即使是 OpenAI 的 o1 系列模子,也无法透顶幸免这些问题。 o1-preview 天然有所矫正,但仍然会犯一些初级诞妄,举例无法知晓“目下”和“旧年”的分离,这可能是因为磨练数据中包含了“通货彭胀”的格局,模子仅仅简便地效法了这种格局

Farajtabar 以为,

LLM 的这些贯通,更好地解释是复杂的格局匹配,而不是真确的逻辑推理。 即使咱们加多数据、参数和筹算量,或者使用更好的磨练数据,也仅仅取得了“更好的格局匹配器”,而不是“更好的推理器”

Denny Zhou (谷歌 DeepMind 的 LLM 推理团队厚爱东说念主) 也参与了探究,他指出:

“这项使命的一个重要发现是:向 GSM8k 问题添加不相关的高下文会导致 LLM 无法处理这些问题,正如咱们在 ICML 2023 年的论文‘大型话语模子很容易被不相关的高下文漫步戒备力’ 中所讲解的那样。领导构建的各别在我看来仍然很真谛。”

Yuandong Tian (Meta AI 的计议科学家总监) 也抒发了他的不雅点:

“中枢问题是:1️⃣凭借咱们的限度学问,咱们不错构建权重,使 LLM 在特定问题中进行精致的推理;2️⃣相关词,梯度下降可能无法学习到这么的权重;3️⃣咱们仍然依赖梯度下降,因为它为好多限度带来了魅力——若是它在其他限度变得愚蠢,咱们也窝囊为力。”

论断

总的来说,这篇论文计议恶果莫得在包括 Llama、Phi、Gemma 和 Mistral 等开源模子,以及最近的 OpenAI GPT-4o 和 o1 系列等起初闭源模子在内的话语模子中,找到任何体式推理的把柄。他们的当作不错用复杂的格局匹配来更好地解释——如斯脆弱,以至于更更称呼齐会使恶果窜改约 10%!咱们不错扩展数据、参数和筹算量——或者为 Phi-4、Llama-4、GPT-5 使用更好的磨练数据。但这可能只会产生“更好的格局匹配器”,而不是“更好的推理器”

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

背负裁剪:刘亮堂